Contents

Come creare un file Robots.txt che ti permette di ottimizzare la scansione dei bot dei motori di ricerca e migliorare il posizionamento SEO?

Questa è la domanda a cui voglio risponderti oggi per mostrarti come un semplice file di testo inserito nel nostro sito può fare la differenza.

Che cos’è il filre Robots.txt?

Il file Robots.txt è un file di testo che viene posizionato sul server e la sua funzione principale è quella di bloccare determinate aree del nostro sito Web dal tracciamento dei bot.

La maggior parte dei principali motori di ricerca (inclusi Google, Bing e Yahoo) riconosce e rispetta le regole scritte nel file Robots.txt.

Sicuramente il tuo sito web ha parti non necessarie e non vuoi che i motori di ricerca perdano tempo a scansionarle.

Se snellisci il lavoro dei motori di ricerca come Google rendendo la scansione del tuo sito il più accessibile e veloce possibile.

Per fare ciò, contrassegnare le pagine come noindex o stabilire suggerimenti come link nofollow può accelerare questo processo di scansione; ma puoi fare molto di più e per questo c’è il file robots.txt.

Perché Robots.txt è importante?

Il Robots.txt non è obbligatorio ma è vivamente consigliato ottimizzarlo perché aiuterà il posizionamento del tuo sito web.

Devi impedire a Google di indicizzare URL non importanti sul tuo sito web, indicando come noindex pagine come “privacy policy” “cookie policy”, ” note legali” “URL con contenuti non ricercati su Google” ecc.

Il file robots.txt è un file di testo semplice con alcune regole che funziona come un filtro per i robot e ti consente di controllare le autorizzazioni di accesso a determinate pagine o cartelle del tuo sito web.

È il primo file che il robot consulterà e tutti i robot accreditati rispettano le direttive nel file robots.txt.

Ci sono 3 ragioni principali per cui dovresti utilizzare un file Robots.txt

- Bloccare la scansione a pagine non pubbliche: a volte sul tuo sito sono presenti pagine che non desideri vengano indicizzate. Ad esempio, potresti avere una versione temporanea di una pagina, una pagina di accesso. Queste pagine devono esistere. Ma non vuoi che persone casuali ci atterrino sopra. Questo è un caso in cui utilizzeresti robots.txt per bloccare queste pagine dai crawler e dai bot dei motori di ricerca.

- Massimizzare il budget di scansione: se hai difficoltà a ottenere tutte le tue pagine indicizzate, potresti avere un problema con il budget di scansione. Il budget di scansione definisce la quantità di risorse che il motore di ricerca è disposto a spendere per la scansione del tuo sito ed è quindi una sorta di indice di gradimento che influenzerà il suo posizionamento. Bloccando le pagine non importanti con robots.txt, Googlebot può spendere una parte maggiore del budget di scansione nelle pagine che contano davvero.

- Impedisci l’indicizzazione delle risorse: l’ utilizzo di meta direttive può funzionare altrettanto bene di Robots.txt per impedire l’indicizzazione delle pagine. Tuttavia, le meta direttive non funzionano bene per le risorse multimediali, come PDF e immagini. È qui che entra in gioco il file robots.txt.

Robots.txt dice agli spider dei motori di ricerca di non eseguire la scansione di pagine specifiche del tuo sito web.

Puoi controllare quante pagine hai indicizzato in Google Search Console

Come creare un file robots.txt

Per vedere se un sito web ha creato un file robots.txt , devi solo indicare dopo il tuo “dominio/robots.txt” .

Esempio: nomesito.com/robots.txt

La creazione del file robots.txt è molto semplice e puoi farlo in diversi modi:

Creare un file.txt e caricarlo nella directory principale del tuo sito web.

Apri un file di testos, indica le direttive che desideri e salvalo con il nome robots.txt.

Ora devi solo caricarlo nella cartella principale del tuo sito web e il gioco è fatto.

Utilizzando un plugin come Yoast Seo.

Accedi all’opzione degli strumenti Yoast e fai clic su Crea Robots.txt.

Come puoi vedere, crea di default un robot predefinito che puoi salvare e lo hai già creato in assenza di indicare la mappa del sito.

Per fare ciò, sia che utilizzi Yoast o il file di testo, devi indicare la seguente riga:

Se utilizzi il plugin Google xml Sitemap:

Mappa del sito: yourwebsite.com/sitemap.xml

Oppure, se utilizzi la mappa del sito Yoast Seo:

Mappa del sito: yourwebsite.com/sitemap_index.xml

Per inserire la mappa del sito all’interno del file robots.txt devi solo copiare il percorso della mappa del sito con il tuo dominio nel file robots.txt

Ricorda di incollarlo alla fine del file robots.txt.

Comandi principali Robots.txt

Per guidare i robot, ci sono alcune regole che devi seguire.

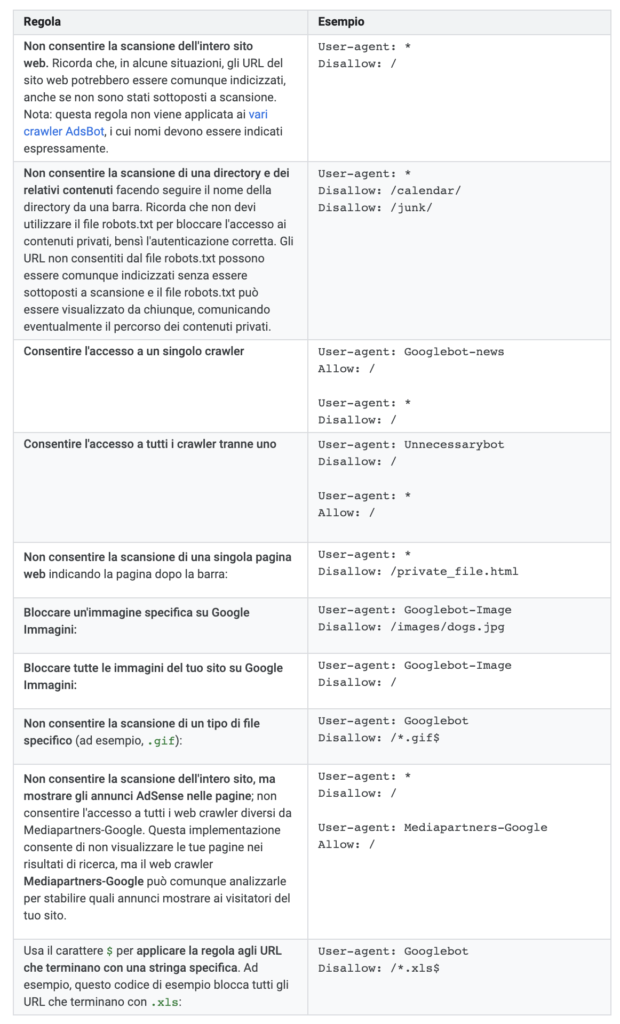

I comandi principali per un semplice file robots.txt utilizzano diverse regole:

User-agent: identifica per quale meccanismo di tracciamento sono incluse le istruzioni

Disallow: indica quali pagine non devono essere analizzate dai crawler.

Allow: indica quali pagine devono essere analizzate dai crawler.

sitemap: mostra la posizione della mappa del sito del tuo sito web, importante per i crawler per trovare nuove voci.

Crawl-delay: dice al robot il numero di secondi di attesa tra ogni pagina. È molto utile per ridurre il carico del server. Il tempo consigliato è di 5-10 secondi, da dinahosting consigliamo sempre 10 secondi.

Puoi anche utilizzare caratteri jolly:

Asterisco (*) : valido per qualsiasi sequenza di caratteri. Ad esempio, tutte le directory che iniziano con “directory” sarebbero “/ directory * /”

Dollar ($) : indica la fine di un URL. Ad esempio, per indicare qualsiasi file che termina con l’estensione .inc dovresti utilizzare “/.inc$”.

Un esempio di un file robots.txt di base:

User-Agent: *

Disallow: /nombrecarpeta/

Sitemap: https://tudominio.com/sitemap.xml

Un esempio di robots.txt più complesso:

User-agent: *

Disallow: /admin/

Disallow: /cgi-bin/

Disallow: /image/

Disallow: /tecnologia/

Allow: /tecnologia/pc

Crawl-delay: 10

User-agent: googlebot

Disallow: /categorie/

Sitemap: https://www.tudominio.com/sitemap.xml

Come verificare Robots.txt?

Una volta che abbiamo il nostro file robots.txt pronto, è il momento di caricarlo affinché Google lo prenda in considerazione.

Per fare ciò, andiamo su Google Search Console e selezioniamo il nostro sito.

Se non lo abbiamo registrato, dobbiamo aggiungere una nuova proprietà con il pulsante rosso nell’angolo destro.

Lo strumento Tester dei file robots.txt ti permette di sapere se il tuo file robots.txt impedisce l’accesso a URL specifici sul tuo sito ai web crawler di Google.

Ad esempio, puoi utilizzare questo strumento per verificare se il crawler Googlebot di Google Immagini riesce a eseguire la scansione dell’URL di un’immagine che desideri bloccare dalla ricerca delle immagini su Google.

Una volta che andremo sul nostro sito dovremo:

Una volta che andremo sul nostro sito dovremo:

Scansione> tester robots.txt

Lì possiamo caricare il nostro blocco note o, se abbiamo già un file robots.txt caricato da prima, modificarlo in tempo reale.

L’unica cosa che dovresti fare è modificare il contenuto dalla casella del contenuto che appare con i robot attuali e fare clic su “Invia” per scaricarlo.

Robots.txt e SEO

I robot possono aiutare molto a monitorare il tuo sito web, ma devi assicurarti che funzioni correttamente.

Una semplice virgola o una lettera maiuscola errata può causare danni SEO significativi.

Se è necessario o meno in tutti i siti dipende.

Devi sapere che, su piccoli siti web con architetture semplici, la verità è che i motori di ricerca lo tracciano senza problemi.

Ci sono anche importanti siti web SEO che dicono di non utilizzare robots.txt poiché Google è abbastanza intelligente da capire un sito web.

Tuttavia, dico sempre che nella SEO tutto aiuta, non importa quanto piccolo .

Se puoi fare in modo che Google assegni le priorità e comprenda meglio il tuo sito, facendoti risparmiare tempo, il mio consiglio è di utilizzare un bot coerente senza impazzire.

Ti consiglio di lavorare sul tuo robots.txt e aiutare la scansione del tuo sito web da parte di Google.

- Guida Canva - Settembre 29, 2021

- Google July 2021 Core Update - Luglio 15, 2021

- Link building SEO cos’è? Guida passo passo - Luglio 10, 2021